去年的 Google I/O 前一天,OpenAI 甩出 GPT-4o 狙击。

今年攻守之势异也。

前几天 OpenAI 透露 GPT-5 将 All in One,集成各种产品。刚刚,Google 就把这个思路贯彻到 I/O 大会,直接掏出了自家有史以来最强的 AI 全家桶。

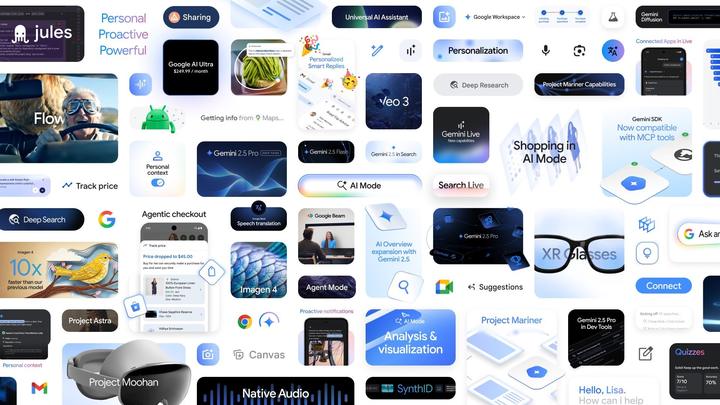

从发布 Gemini 2.5 Pro 与 Flash 两款模型,到 AI Mode,再到 Veo 3、Imagen 4,以及面向开发者与创作者的 AI 套件等,Google 几乎把从模型到产品的路径都压缩到一场发布会里。

更准确地说,当下最火的 AI 应用场景,都被 Google「预埋」进了产品接口里,让人意识到它仍是全球最具工程实力和生态整合能力的 AI 巨头之一。

也难怪许多网友调侃,将近两个小时的发布会过后,又将有一大批初创公司死于 Google 之手。

不过,也不难看出,发布会上有一些功能仍停留在「预告片」和小范围测试阶段,距离真正的落地或许还有不小的距离。

帮我「买票 + 找座 + 填表」一口气搞定,Google 新 AI 搜索卷疯了

AI 正在重写搜索这件事的底层逻辑。

在去年的 I/O 大会上,Google 推出了 AI 概览(AI Overviews)功能,至今已拥有超过 15 亿的月活跃用户。

生成式 AI 逐渐改变了人们的搜索方式,但随之而来的却是,我们不再满足于在搜索框里输入简单的问题,而是抛出更复杂、更长、更具多模态的提问。

今天,Google 再次加码搜索与 AI 的融合,推出一种端到端的 AI 搜索体验——AI Mode。

正如 Google CEO 桑达尔·皮查伊介绍的那样,这是 Google 有史以来最强大的 AI 搜索形态,不仅具备更先进的推理能力和多模态理解能力,还支持通过上下文追问和网页链接进行深度探索。

例如,当用户面对一个需要复杂解读的搜索问题,AI Mode 可启动「深度搜索」机制,不同信息之间进行推理,并在几分钟内生成一份专家级的引用报告,为你节省数小时的研究时间。

与此同时,Google 也将 Project Astra 的多模态能力接入搜索,进一步提升搜索的实时交互性。通过 Search Live 功能,用户只需打开摄像头,即可通过画面实时提问并获得反馈。

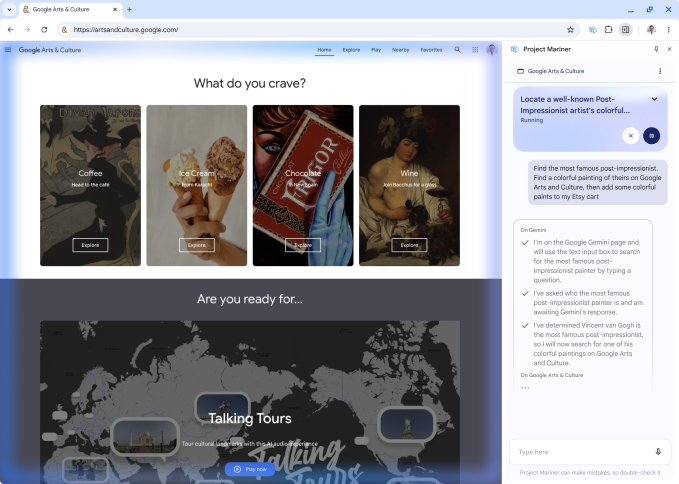

今年是 Agent 元年,Google 也很贴心地推出了 Project Mariner Agent 功能,能帮助用户更高效地完成任务。

例如,只需一句「帮我找两个这个周六比赛的实惠票,位于下层座位」,AI Mode 便能自动跨多个票务平台检索选项,实时比较价格和库存,并完成表单填写等繁琐操作,大幅提升效率。

借助 Gemini 模型和 Google 购物图谱的强大支持,Google AI Mode 能够帮助你缩小商品范围并提供灵感。如果你想看看衣服穿在自己身上的效果,只需要上传一张自己的照片,就能实现虚拟试穿衣服。

此外,AI Mode 也具备强大的个性化能力,能根据用户上下文偏好给出定制化建议,还可生成图表和可视化结果,尤其在体育和金融类搜索中表现出色。

该功能今日起已在美国全面上线,未来将推广至更多地区。

会写代码、还省 Tokens,Gemini 2.5 拿到「学霸」人设

在模型能力方面,Google 此次发布了 Gemini 2.5 Pro 的 I/O 版本,在各大排行榜上独占鳌头。

现在,Gemini 2.5 Pro 引入了名为「Deep Think」的推理增强模式。这项功能可在生成答案前考虑多个假设,从而更深入地理解问题背景。

2.5 Pro Deep Think 在 2025 年美国数学奥林匹克(USAMO)以及 LiveCodeBench(编程基准)排名领先,并在 MMMU(测试多模态推理)中获得了 84.0% 的分数。

不过,Google 表示,将会花更多时间进行前沿安全评估,并征求安全专家的进一步意见。作为第一步,Deep Think 功能目前将通过 Gemini API 向小范围测试者开放。

同样得到升级的还有注重效率的 Gemini 2.5 Flash。

新版 2.5 Flash 在推理、多模态、代码和长上下文等关键基准上都有了改进,同时在效率上更高,评估中使用的 tokens 减少了 20% 至 30%。

2.5 Flash 现已在 Gemini 应用程序中向所有人开放,并将在 6 月初通过 Google AI Studio 面向开发者和 Vertex AI 向企业全面发布。

开发者体验上,2.5 Pro 和 2.5 Flash 将在 Gemini API 和 Vertex AI 中引入了「思维摘要」功能,可将模型的推理路径以标题、关键信息和调用工具等方式进行结构化呈现。

开发者也将从中受益,Google 宣布在 Gemini API 和 SDK 中正式支持 MCP 工具,让开发者可以轻松接入更多开源工具和插件生态。

音乐、电影、图像全套上线,Google 把 AI 玩出了花

本次发布会,Google 带来了新一代图像和视频模型——Veo 3 和 Imagen 4。

与传统视频生成不同,Veo 3 是一款支持音频的视频生成模型,能在城市街景中模拟交通、鸟鸣,甚至角色对话,显著提升沉浸感。

该模型不仅在文本和图像提示的基础上生成视频,还能精确实现物理环境与口型同步,极大提升了视频创作的真实感。

目前,Veo 3 已在 Gemini 应用和 Flow 平台上向 Ultra 订阅用户开放,并已在 Vertex AI 平台上为企业用户提供支持。

上文提到的 Flow 正是 Google 为创作者打造的一款 AI 电影制作工具。

用户只需用自然语言描述电影场景,即可管理演员、地点、道具和风格,自动生成叙事片段。Flow 已在美国向 Gemini Pro 和 Ultra 用户开放,全球范围的推广也在推进中。

在图像生成方面,新版 Imagen 4 提升了精度与速度,细节表现上可逼真展现织物、水滴与动物毛发,同时也能生成偏抽象类型的风格。

它支持 2K 分辨率和多种长宽比生成,在排版和拼写方面也有显著优化,适合制作贺卡、海报甚至漫画。

Imagen 4 今日已在 Gemini、Whisk、Vertex AI 以及 Workspace 的 Slides、Vids 和 Docs 中上线,据悉,未来还将推出速度快十倍的版本。

在音乐创作方面,Google 扩大了 Lyria 2 驱动的 Music AI Sandbox 的访问权限,并上线了互动式音乐生成模型 Lyria RealTime。该模型现已通过 API 和 AI Studio 向开发者开放。

考虑到由 Veo 3、Imagen 4 和 Lyria 2 生成的内容将继续带有 SynthID 水印,Google 发布了全新的 SynthID Detector。

用户只需上传文件,即可识别其中是否包含 SynthID 水印,用于防伪和追踪 AI 内容来源。

Google 要造「世界模型」,连任务都能帮你做了?

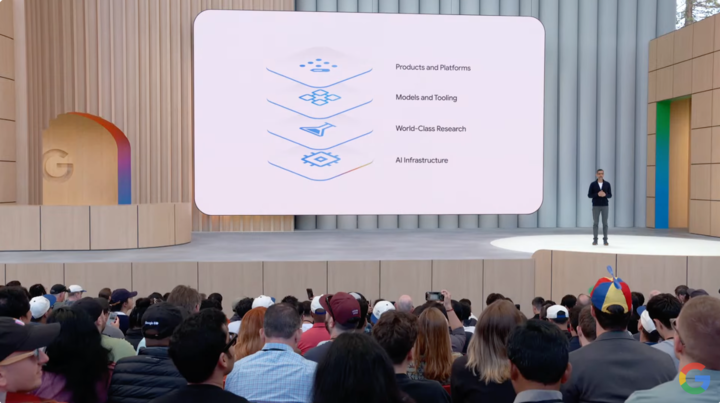

Google 希望将 Gemini 打造成一个「世界模型」,既能计划、理解,也能模拟现实世界的各个方面。

Google DeepMind CEO Demis Hassabis 表示,这一方向正是 Project Astra 的核心理念之一。

过去一年里,Google 已将视频理解、屏幕共享、记忆功能等逐步集成进 Gemini Live。如今,Gemini 新的语音输出加入了原生音频,更加自然;记忆与 computer use 能力也同步增强。

此外,Google 还在探索如何利用 Agent 能力帮助人们处理多任务。

Project Mariner 就是其中之一,能够同时完成最多十项任务,比如信息查询、预订、购物与调研。已面向美国 Ultra 用户开放,并即将集成至 Gemini API 与其他核心产品中。

AI 新功能扎堆发布,会诞生真正的杀手锏吗

NotebookLM 官方昨日宣布,上线 24 小时就已经成为 App Store 中排名第 2 的生产力应用和第 9 的整体应用。

作为 Google 在 AI 笔记工具上的一次重要探索,NotebookLM 提供音频概览和思维导图等功能。

其中,音频概览目前已支持超过 80 种语言,而本周,Google 也宣布将为这一功能引入更高的可定制性,用户可根据需要选择摘要的长度,无论是快速浏览还是深入阅读都不在话下。

这项功能首先将在英语中推出,随后将扩展到更多语言。

与此同时,Google 也在回应用户对视觉呈现的诉求,即将在 NotebookLM 中加入视频概览功能,用户只需一键即可将笔记内容转化为教育类视频,用更直观的方式传递信息。

在 AI 编程领域,Google还带来了 Jules 的最新进展。

这个最初出现在 Google Labs 的自主编码助手,能够理解代码并自主完成诸如编写测试、构建功能和修复 Bug 等开发任务,如今已经正式进入公开 Beta 测试阶段。

此外,Google 还推出了全新的订阅服务 Google AI Ultra。

该计划为专业用户提供 Google 最强大模型和高级功能的无限制访问,适合电影制作人、开发者、创意工作者等专业人士,月费为 249.99 美元。

目前,该计划已经在美国上线,并将很快扩展至其他国家。

实际上,AI 如今不缺模型,也不缺功能,真正稀缺的,是一个能嵌入日常生活、真正打进主流用户心智的「杀手级产品」。

Google 当然明白这个道理,也正全力以赴寻找答案。

因此,我们看到,在这次的发布会上,Google 几乎什么都做了,也什么都提了:从文本、图像、视频、音乐,到搜索、Agent、创作工具,一应俱全。

牌已经亮完,技术也到位,现在,Google 只差一记真正击中用户痛点的落子。