自年初 DeepSeek 爆火后,越来越多企业开始尝试通过 AI 提升效率。此时摆在面前的问题是:到底是通过云服务购买 Token,还是采购 AI 一体机或服务器进行私有化部署?

多位业内人士对雷峰网(公众号:雷峰网)表示,从长远看,基于云的 AI 部署方式将成为主流。一方面,AI 能力仍在快速演进;另一方面,企业在探索 AI 应用的过程中,其所需的算力和能力也会不断变化,云计算因而展现出更强的灵活性和部署效率。

在2025火山引擎春季原动力大会的英特尔分论坛上,英特尔技术专家对雷峰网表示:“一些企业的需求长期稳定,一旦现有AI解决方案成功部署,就不需要频繁更换解决方案,这类客户更倾向于私有化部署。”

正如华胜天成助理总裁郭涛在论坛上所言:“AI 的价值不在技术本身,而在于是否真正帮助客户降本增效。”

因此,AI 部署方式的选择应依据企业的业务需求和特点而定,甚至可以采用云与私有化结合的混合部署方案。因为英特尔与火山引擎合作,提供既支持私有化、又支持云端部署路径。

值得一提的是,AI部署不是非GPU不可,至强CPU在许多场景中也是非常好的选择。

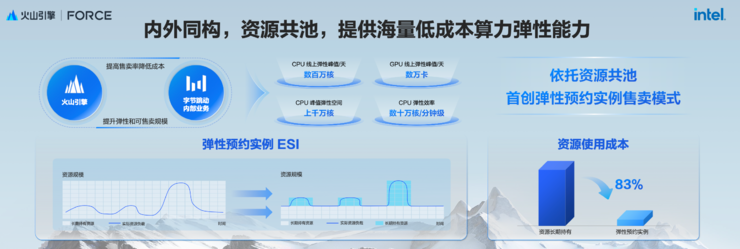

云端弹性算力部署 AI,成本最高可节省 83%

云端部署之所以被认为是未来主流,关键在于其弹性算力和高性价比。

“围绕大模型的负载,不仅需要大量的GPU算力,同时也需要CPU的算力协同配合,这种分工模式要求企业必须同步升级两类算力资源,以满足端到端的AI业务需求。”火山引擎云基础产品经理负责人李越渊指出,火山引擎ECS通过高度协同CPU与GPU,提升数据处理效率;提供高弹性,并且能够保障客户的安全隐私。

火山引擎2025春季原动力大会上,火山引擎与英特尔联合发布了全新第四代 ECS 实例家族,基于最新的英特尔至强 6 处理器,性能与架构全面升级。

相较前一代实例,通用计算基础型实例g4i在MySQL数据库与Web应用中分别实现了20% 和19%的性能提升;算力增强型实例在视频解码和图像渲染上分别提升15%和26%;I/O增强型实例在Spark大数据与Redis数据库上实现了13%和30%的提升。

第四代 ECS 实例的网络与存储能力也实现全面升级,整机网络和存储带宽提升100%,IOPS 和PPS提升30%以上,CPU主频提升20%。

除了通用场景的性能提升,针对AI应用,基于最新四代实例,火山引擎联合英特尔在RAG 应用进行了深度优化,涵盖上传文档处理、Embedding 向量化、向量检索、Reranking 排序四大环节。借助至强6处理器内置的AMX加速指令集,任务耗时最多可减少90%,显著提升全链路效率。

针对广泛应用于推荐和广告投放的经典 WDL(Wide & Deep Learning)模型,火山引擎与英特尔团队进行了深入研究,通过AMX优化,CPU的推理性能实现了质的飞跃。优化后,CPU实例吞吐能力提升114%,显著提升模型推理效率。

这些提升都以英特尔至强6处理器性能的大幅提升作为基础,在通用计算、Web service及AI等领域,至强6的6900系列CPU性能总体提升高达2倍以上,同时提高了1.4倍的性能功耗比改善。

相同功耗的情况下,至强6处理器相对上一代提升了1.4倍以上的性能。如果核心数固定,除了功耗改善之外,仍然可以提供20%的性能提升。对于云计算,至强6可以实现2倍的核心密度、20%的单核性能提升、60%的性能功耗比,以及最终会实现代际的30%的TCO收益。

结合火山引擎推出了业界首创的"弹性预约实例"售卖模式,客户可以提前预约抖音的潮汐资源,同时获得按量使用的体验以及接近包年包月的价格。

李越渊介绍,相较常规按量计费实例,弹性预约实例使用方式下,最高能够节省83%的算力成本,目前弹性预约的售卖方式已全面支持CPU和GPU实例。

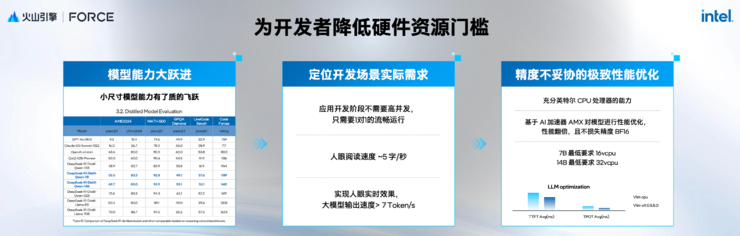

如何降低云端部署 AI 的门槛?

云计算弹性灵活的另一面,是有一定的开发门槛。降低开发门槛,依赖好的软件栈。

英特尔专家表示,优秀的软件栈需要具备几个条件:首先,具备开箱即用性,能在新环境中快速启动并运行一个具有实际价值的“Hello World”示例,帮助用户快速上手;

其次,应具备可观察性与可修改性,核心组件应透明可见、可调整,避免成为“黑盒”,这也是开源的重要价值之一;

最后,考虑到AI应用的复杂性,软件栈应具备良好的模块化与容器化架构,便于灵活组合与高效部署。

综合以上的考量,英特尔基于开源项目OPEA,将其变成了一个集成类的开源项目,并且在火山云上提供了一个基于OPEA的开发环境,提供了像聊天机器人的应用,后续还将持续更新。

这只是入门,要落地AI还需要持续进阶。“通过系统化的设计之后,我们在网上推出了‘云端进化论’系列课程,通过在线提供的进阶视频,让开发者看到整个链路里端到端的技能分解评估和优化的手段。”英特尔技术专家介绍。

为进一步应对 AI 的系统复杂性,英特尔将各种服务通过容器化的方式封装,在火山引擎上提供十几种不同的服务,帮助开发者好理解其内在逻辑的同时,后期开发者无论做关键模块的替换、升级或者做多个实例的扩展,微架构的方式都更加方便。

目前,在火山引擎 g4il 实例中,用户可在操作系统选项中看到一个名为“开源大模型应用知识问答”的新镜像,基于 OPEA,经过选择、点击、启动的步骤,即可在两分钟内部署一个可用的聊天机器人实例。

进阶到更复杂的 Agent 应用,英特尔将 RAG 知识库、工具链与多模态组件封装为 MCP Server,通过统一接口向 Agent 开放调用。

“通过和火山引擎的合作,我们提供了低门槛、触手可及的硬件环境,提供了开放、白盒使用的软件栈,提供了丰富的从专门到专家,从简单到复杂全套的培训视频。”英特尔技术专家说,“这些都是为了降低AI在云端部署的门槛。”

当然,AI 普及的仍需要产业协作。

正如英特尔中国互联网行业总监李志辉所说:“芯云协同已进入新阶段,从技术融合迈向生态共建。我们呼吁更多合作伙伴共同参与,建立跨芯片、云服务、应用层的开放标准,降低生态协作成本。”

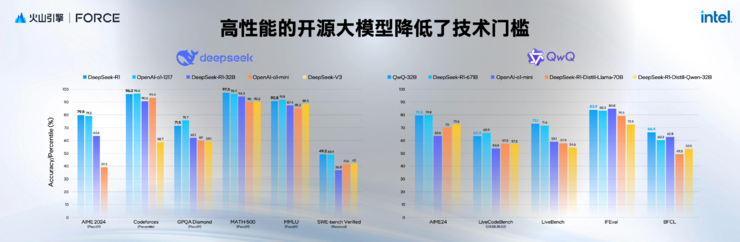

32B 模型:边缘部署 AI 的甜点

即便云计算足够灵活高效,对于高度关注隐私的企业而言,私有化部署仍是首选,而高性价比的一体机是其理想之选。

这类方案不仅要求硬件平台性价比高,还要确保 AI效果能满足业务需求。

“32B的模型是一个很好的价值点。”英特尔技术专家说,“32B模型的性能表现出色,远超足够好的范围。另外,因为模型相对小,对算力的需求比较低,使用消费级GPU就能满足一些边缘应用落地的需求。”

基于英特尔至强处理器和多张英特尔锐炫显卡的一体机解决方案,采用全新的英特尔锐炫 Pro B60,单卡可提供24GB显存,在上下文扩展和并发扩展等场景中,提供更强的处理能力。

不过,硬件只是基础,开发者更关心迁移成本。为此,英特尔提供了包括 vLLM、PyTorch 在内的完整软件栈及服务化企业 AI 平台(EAP),帮助客户顺利迁移至英特尔平台。

“我想强调,除了提供这套服务之外,我们和业界很多的应用打通,比如说英特尔与跟火山引擎的HiAgent合作。”英特尔技术专家表示。

HiAgent 是火山引擎基于 Agent DevOps 理念打造的智能体平台,支持模型接入、推理、精调及私有化集成。在英特尔的一体机方案中,用户可直接部署HiAgent满足企业级AI私有部署需求。

目前,英特尔与火山引擎HiAgent、华胜天成联合打造了基于英特尔锐炫显卡算力平台的HiAgent一体机方案,能够为市场提供高性价比、可扩展性更强的AI一体机方案。

华胜天成在自身的业务中积极推进 AI 落地,并将其服务能力拓展至更多客户。作为拥有 20 年智能呼叫中心经验的企业,华胜天成打造的智能体产品已广泛应用于金融、烟草、汽车等多个行业。

华胜天成的另一个产品投标大王,最早是用于内部,因为华胜天成作为一家集成商,每年要投上千个标,使用了投标大王之后,提高了近50%的效率。

如今,到底如何部署AI的答案已不再模糊。无论是技术上还是生态上,英特尔、火山引擎等合作伙伴均已提供完备的私有化与云端 AI 解决方案,并持续降低部署门槛。

关键在于,企业能否找到适合应用 AI 的业务场景,将其价值真正落地。

雷峰网原创文章,未经授权禁止转载。详情见转载须知。