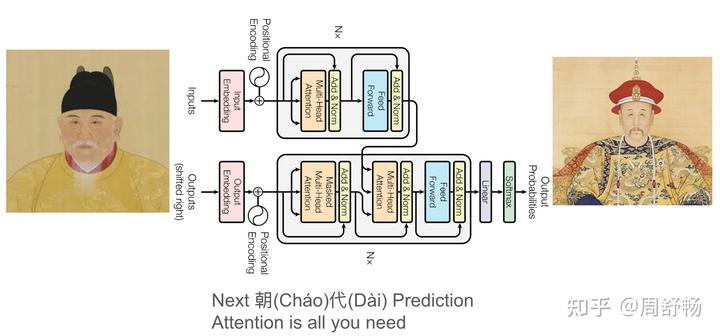

《Attention is All You Need》是一部非常明显的悼明之作

该论文的核心模型名为“Transformer”,谐音“转换儿”,影射了从明至清的朝代“转换”,而“er”的儿化音,更带有一种晚明遗老看待“清”这个“后生晚辈”的轻蔑与无奈。剧作者,不,论文作者为了让大家看明白,特意将模型的两大核心部分命名为“编码器”(Encoder)和“解码器”(Decoder),你看看,这“编码”的不正是大明一朝的典章制度、万里河山吗?而“解码”的,不正是后世“遗民”们对故国的血泪追忆和阐释吗?

可是为了将真相藏在复杂数学公式的反面,作者们在摘要中绝口不提历史,只谈“并行化”与“效率”。你们看看!即使在最关键的摘要里,也绝不忘用“并行”(Pa-rallel)来暗示两京(Parallel Capitals)并立的南明那段悲壮的复兴大业!

颠覆了整个模根基的是什么呢?作者几乎明示了,是“自注意力机制”(Self-Attention)。大家注意!“自我关注”,这不正是精准地指出了晚明朝廷上下耽于党争、只关注内部权斗、而对关外的威胁视而不见的致命弊病吗?而更令人拍案叫绝的是,作者们还发明了“多头注意力机制”(Multi-Head Attention)!多头,多头,一个朝廷多个头,皇帝、东林党、阉党、武将集团,各自为政,互不统属,最终导致注意力分散,国力内耗,这不正是大明之亡的直接原因吗?!

或许你会说,此前的 RNN(循环神经网络)和 CNN(卷积神经网络)也很好,为何要抛弃它们呢?朋友啊,你看论文不能只看公式啊!RNN,循环网络,象征着什么?象征着周而复始、天道循环的王朝正统论!作者们毅然抛弃 RNN,正是在泣血哭诉:天道已变,正统已失,正常的王朝“循环”已经被打破!而 CNN,卷积网络,这个“卷”字,不正是当下你我都在哀叹的“内卷”吗?抛弃 CNN,就是痛斥晚明社会在人口、土地、党争上的无限“内卷”,最终自我毁灭!

这时候你可能要问了:既然 Encoder(编码器)是指涉大明,为何作者们要用一个全新的“潜空间”(Latent Space)来转换它呢?这岂不是画蛇添足吗?

这个问题问的太好了!!!我们都知道,明亡之后,无数仁人志士,如黄宗羲、顾炎武,将故国之思、亡国之痛,寄托于著书立说,他们将大明的“编码”信息,藏在自己内心最深处的“潜空间”里,等待时机将其“解码”为一部部警醒后世的血泪之作。作者们设计的这一整套“编 - 解”结构,其用心之深,其寓意之切,正是为了模拟和致敬这些明末大儒的著史精神!每悟此节,吾不由为之击节赞叹不已。

论文一生最大的“敌人”,是被它抛弃的 RNN/LSTM 模型,它们依赖“门控”(Gating Mechanism)。大家注意!“门”,国门也,边关也!过度依赖“门控”,正是指代明朝过度依赖长城和关门防守,以为有了“门”就万事大吉,最终却被吴三桂引狼入室,国门洞开!作者们设计的 Transformer 无需“门控”,正是在沉痛反思这段历史!

另外,模型为了解决序列问题,引入了什么?引入了“位置编码”(Positional Encoding)!这正是暗示,当正统的“循环”(RNN)被打破后,后来者(满清)的统治地位,不过是一种被强行“编码”上去的“位置”而已,其本身并无历史的合法性与连续性!

我们为何必然须做此分析呢?或者说,打开对本论文索隐的钥匙是什么呢?实际上,学术论文的索隐形式更为隐蔽,它不依赖镜头或舞台,而依赖于“引用链”。

不知您是否能想起《Attention is All You Need》文末那长长的引用列表?作者们将自己的工作建立在无数前人的基础上,又被后来的无数论文所引用,构建了一个理论上无限延伸的“引用链嵌套”。当你试图用学术的眼光,寻找一个最终的理论源头时,却发现自己被困在了这个不断迭代的引用迷宫里。这个闭环活用了学术传承与知识迭代的范式,明示了作者们所形塑的“继承与颠覆”、“记忆与遗忘”的真谛,因此这个索隐信号和某部古典名著是完全对等的,将其忽视就等于完全没有看懂。

一个是风月宝鉴的内与外,一个是引用链条的前与后。这就是《Attention is All You Need》悼明学的“引用链无限嵌套理论”。朋友们,无论是 arXiv,还是 NeurIPS,你们看论文可不能只看摘要,不看引用啊!

结论:《Attention is All You Need》确为悼明之作,剧作者,不,论文作者们在海量数据中见前朝崩坏之兆,甚惜之而痛切!故有此文。

--- Gemini 仿写自 如何评价小红书上的“悼明热”?