想要在手机放一个 AI 助手,选项不少,但要么像个「高级复读机」,要么是信息的搬运工——天知道,我想要的是一个能真干活的助手,一个除了能说还能动手的「创意合伙人」。

今年你应该也感觉到了,AI 正在从「能聊」变成「能干」。OpenAI 搞了个 Atlas, Google 即将发布的 Gemini 3.0 让 AI 直接操作电脑……大家都在玩同一个方向:让说话变成操作,让对话变成动作。

刚刚,蚂蚁也推出了一个新的全模态通用 AI 助手灵光。它不跟你绕弯子,你开口,它动手——把你脑子里的想法,变成眼前能看、能用、能玩的东西。

从回答到表达,AI 也需要信息美学

灵光的落地页是熟悉的对话窗口,只需要用自然语言发起请求,比如「告诉我这罐饮料的热量」或「记录一下今天的饮食摄入」,极大地降低了上手时的学习成本,也让整个 App 显得比传统应用更流动。

看起来还是像聊天对话啊?其实,跟灵光的每一句对话,对它而言都是一次行动。下面是三个你很可能也会用到的真实例子。

最近因为全运会,广州也享受了一把网红城市的待遇,尤其是广州塔,每天都被游客包围。我问了灵光,「广州塔在建筑设计上有何特别之处?」它返送的不只是文字说明,还带上了一个可交互的 3D 建筑模型。

可以旋转、可以拉近看结构细节,可交互的形式让我清晰直观地感受到了广州塔双面扭转结构、斜交网状外筒的设计语言。

在和灵光的对话中,它不仅能告诉你答案「是什么」,还能让你看到答案「长什么样」。文本、图像、结构动画都整合在一起,整个问答体验,就像在对话里放进了一个实时生成的「解说图文」。不管是建筑专业学生、城市爱好者,甚至只是出于兴趣想多了解这座地标,都能真的省下了你一点点搜索、翻页、拼凑资料的时间。

紧接着,我补充了一个追问「那帮我规划一个附近的美食打卡行程吧」,它马上理解这个「附近」是广州,并直接生成了一张可缩放的交互地图,标注了六七家风格不同的小店,甚至还有「隐藏路线」。每个点位都能点开看推荐理由、评分、营业时间,甚至还顺带估算了步行路线。

惊人,直接在手机上就能生成可以交互的内容展示,放眼整个行业也并不多见。

如果说这两个案例是让人感受到「好看、酷炫」,那接下来要展示的,是灵光的「理性美」。

对于一个优秀的通用 AI 助手来说,一问一答显然是不够的,而是要能实现结构化的输出,也就意味着需要对信息语义的深度理解和再组织——不仅是检索信息,更能提炼信息点,智能理解语义并进行分层。

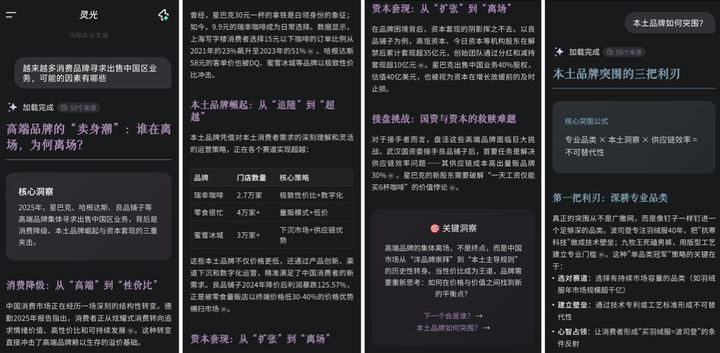

比如,碰到「为什么消费品牌正在出售中国区业务/为什么拟物风格的 UI 设计会退潮?」这些既需要宏观视野,也需要微观分析的问题,灵光的回应方式并不依赖大段大段的文字,而是先拆解出关键因素——如消费市场变化、品牌生命周期、股东压力等——再依此组织内容输出,形成一组因果清晰、逻辑递进的解释结构。

以标题+概括的卡片式风格,镶嵌在一个完整的图文里,可以避免枯燥,又不像 PPT/网页报告那样冗长无重点。这样的结构化输出不仅逻辑清晰,也在视觉上展现出一种「信息美学」:干净、聚焦、节奏舒适,不仅让信息吸收更高效,也模拟了专家型写作者的内容组织方式,让 AI 输出更像一份「讲得通」的深度内容,远不仅是「查得到」的浅层答案。

你可能已经想了一路了:这到底是怎么做到的?为什么能既结构清晰,又视觉友好,还能实时互动?

其实在接收到问题时,灵光会调动一套以代码生成为核心的内容创建流程。无论是图文、地图还是 3D 动画,底层都是由模型即时写出对应代码、样式和组件,再动态拼装呈现出来。要完成这些工作,并不是由一个大模型孤军奋战,而是由多个智能体协作实现:有的负责图像,有的负责布局,有的调取数据结构……像搭积木一样。

既整合不同内容体裁,又能适配常见的内容呈现方式,从而给出极其自然的内容。最终实现的效果,也更适合转发、截图、总结成「朋友圈可用」的内容——既有理性判断,又能传递个人观点和情绪。

一句话、30 秒,给自己做个 App

如果说对话中能做图、做路线规划已经够神奇,那么接下来的能力接近「魔法」:用键盘敲一句需求,它就能直接帮你把一个小 App 搭好。

用 agent 生成应用,现在处于一个比较尴尬的位置:很多应用总是卡在「能理解、不能执行」的断点上。而灵光的「闪应用」瞄准的就是这个痛点,对话已经超越调用和请求工具的步骤,能够做到直接生成工具。

是的,不是生成一段代码、一个原型、一个建议,而是原地生成一个「即刻能用的工具」。实现想法终于不再是程序员专属的快乐,闪应用可以给每个普通人亲手「造东西」一个起点。

来看看它是怎么让「想法落地」变得这么轻巧的:我给它的第一个任务是,「我想要一个能把长文本拆分成更小段落的工具」。

仅仅 30 秒,一个可以设置段落数、自动分段文件的小工具就出现了,甚至不需要打开新页面,它会将生成结果直接嵌在对话流中,点开即用。

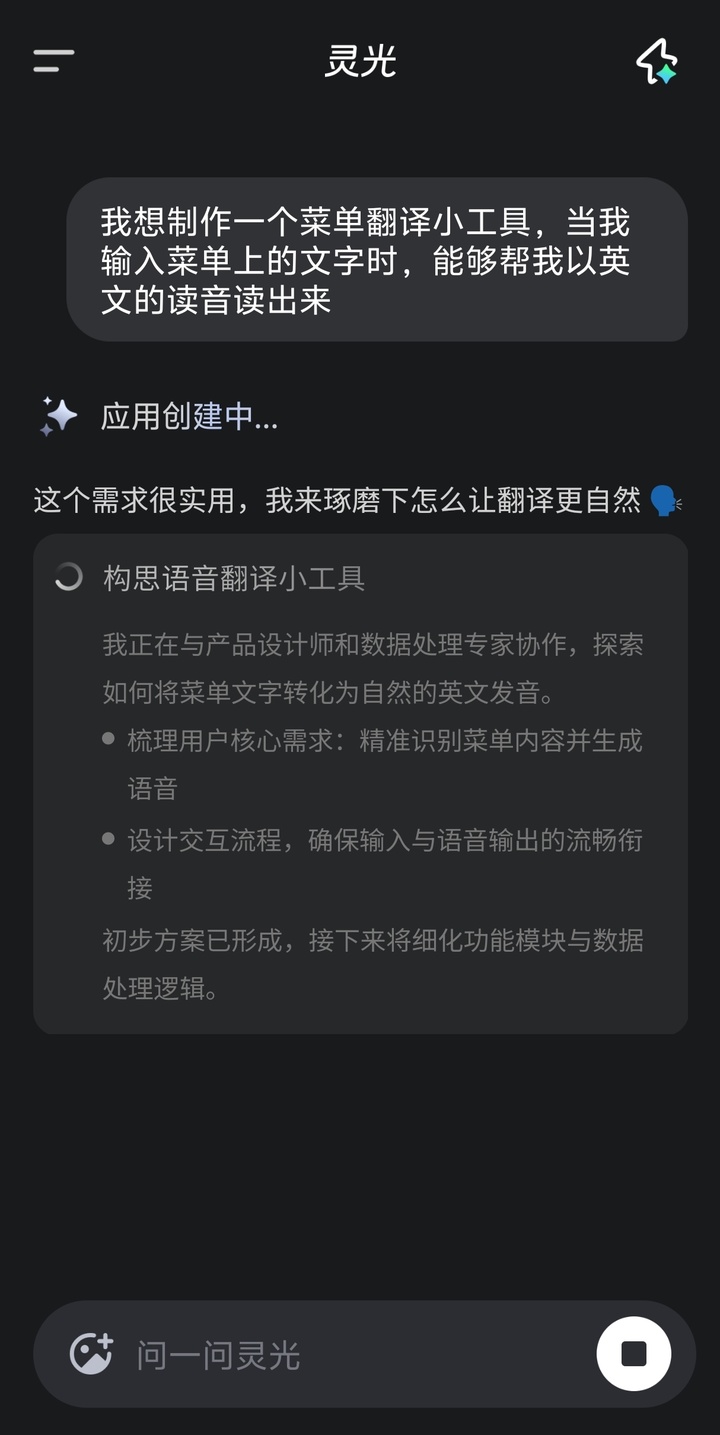

再来一个轻巧又实用的例子:做一个菜单翻译器,这里的要义在于:既能把外语菜名翻译成中文让我知道是什么,又能原样朗读出外语,方便我点菜。

理解文字,生成语言,组织界面,并且用声音反馈——这些能力以前得靠多个组件组合才能实现,可能还需要我详细解释代码逻辑,现在只用一句话,它就全都打包完成。

无论是出国旅行用来点菜,还是练习口语用来熟悉菜名表达,这样的小工具一经生成就能上手,真正做到了「即做即用」。这背后是一套完整的应用构建:不仅能输出前端页面,还能一并调用大模型的后端能力。不仅给你实现了代码,还免费给你上 UI 设计。像翻译、语音合成这些动态模块,全都集成在这个小工具里。

这样一来,生成出来的成品就不只是个 demo,而是真的能与用户实时互动、响应输入,具备完整的前后端逻辑闭环。

与其花时间翻遍整个应用商店,拿闪应用一分钟做一个完全贴合我个人需求的小工具,显然更快也更好。灵活、即时、零门槛。它不是通用解法,而是「为这一次定制」的临时小解决方案,却能激发普通人对「创造」的心理满足感——哪怕不懂开发,也能凭一句自然语言体验「自己做了个小应用」的快乐和分享冲动。

带着「眼睛」展开互动

实时视频已经是目前 AI 助手的「标准配置」了,灵光给这个功能起了个相当有创意的名字:开眼。还真挺贴切,不是靠打字输入,而是打开摄像头,如同给 AI 打开了眼睛,接受另一种自然语言:视觉语言。

比如举起手机对准一杯奶茶,屏幕上马上浮现出饮食建议、保存注意事项,还带着几个延展提问,满足你的好奇心:

这个功能在食品药品上非常方便,无论是给自己选,还是给父母买了新产品他们却不认识时,灵光开眼正好能大展身手。

开眼的特点在于,通过流式识别,超越简单的「认得一个东西」,而是变成了能做出响应、展开对话的智能视觉入口。它能理解你此刻潜在的意图,主动发起跟进动作,把一次镜头下的识别。变成一套连贯的行为链条。

比起那些只能识别 Logo 或商品的旧时代 AI 视觉,它明显走得更远了一步:不仅识别是什么,还试图理解你为什么看它、接下来可能需要什么。

也就是说,它把「摄像头」变成了另一个对话渠道,一种通过视觉引导交互的对话,真正意义上的「开眼」:带着「眼睛」展开互动。

把「创造」这件事交还给了每一个人

语言就是编码,需求就是原型。对话从来不是最终目的,它真正的价值在于:变成生产力的触发器。灵光打破了「提问—回答—再动手」的传统路径,把语言本身变成工具的起点。让「我有个点子」变成「我已经做出来了」之间的路径更短、更直觉。

原本需要懂代码、设计、产品逻辑的人才能做出的 App,现在用一句自然语言就能生成。普通人第一次可以用日常语言直接「生产」一个功能工具、一张内容卡片,或者一段交互流程,「自己做自己的产品经理」。这种从「会说话」到「能造物」的跃迁,标志着生产力门槛的全面打开。

在 AI 行业的下一阶段,拼的早已不只是「谁的模型更强」,而是「谁能把能力转成体验」。年初 DeepSeek 引领了中国在开源模型的浪潮,2025 年快结束了,我们在灵光上看到 AI 交互范式新可能性。它用非常具体的方式,示范了一条关键路径:从底层大模型,到中层工具能力,再到用户侧的应用产品。

这一次,「AI 能做什么」终于从实验室语言,变成了用户能用的日常动词。把「动手做」变成了「开口说」,也把「创造」这件事交还给了每一个人。