2025年12月12-13日,第八届GAIR全球人工智能与机器人大会在深圳·博林天瑞喜来登酒店正式启幕。

作为AI 产学研投界的标杆盛会,GAIR自2016年创办以来,始终坚守“传承+创新”内核,始终致力于连接技术前沿与产业实践。

在人工智能逐步成为国家竞争核心变量的当下,算力正以前所未有的速度重塑技术路径与产业结构。13日举办的「AI 算力新十年」专场聚焦智能体系的底层核心——算力,从架构演进、生态构建到产业化落地展开系统讨论,试图为未来十年的中国AI产业,厘清关键变量与发展方向。

GAIR 2025「AI 算力新十年」专场上,清华大学深圳国际研究生院副教授王智发表了题为《工业机理 × 大模型:行业大模型的系统约束与可控推理的研究进展》的主题演讲,系统阐述了他对工业大模型训推和落地实践的核心判断。

当智能制造从自动化走向智能化,工业大模型被视为关键一跃,却也直面着真实产线中数据稀缺、算力受限、成本敏感的三重挑战。这不仅是一个算法问题,更是一个需要贯通学术前沿与产业实践的复杂系统工程。

在此背景下,清华大学深圳国际研究院的王智教授与其联合团队,选择了一条“从场景中来,到场景中去”的攻坚路径。他们依托国家基金委重点项目,联合深圳信息职业技术学院、汇川技术等合作伙伴,在过去一年里,将研究扎根于工业质检、具身智能、程序生成等具体场景,试图拆解并回应那些最实际的问题:如何用大模型升级传统规则系统?如何让机器自主理解并执行任务?如何在弱算力、弱网络的工厂环境下,让智能模型真正“跑起来”?

与单纯追求模型规模的常见叙事不同,王智教授团队的工作呈现出鲜明的“工程思维”与“成本意识”。他们的探索从底层的数据生成与表征优化出发,延伸至模型规划、分布式训练与推理加速的全链路,其目标并非打造一个万能的“工业GPT”,而是构建一套能让大模型技术适配工业严苛约束、实现低成本高效部署的方法论体系。

这背后,是一个更为深刻的议题:当通用人工智能的浪潮席卷而来,工业领域究竟需要怎样的大模型?它的知识如何注入机理与约束?它的智能又如何与机器人、产线、网络环境协同共生?王智教授的汇报,正是对这一议题的一次阶段性答卷。

以下为王智教授演讲精彩内容的精编整理,雷峰网(公众号:雷峰网)作了不改变原意的编辑:

非常荣幸能在此与大家分享我们的研究工作。

我们团队承担了国家基金委的重点项目,此次汇报主要涵盖项目启动大半年来取得的研究进展。需要说明的是,今天所展示的成果,是我们与深圳信息职业技术学院、汇川技术联合团队共同完成的。同时,我们也基于此基础,与普渡科技、越疆科技合作开展了深圳市重点研发计划项目的研究,相关内容也一并向各位汇报。

首先介绍项目背景。当前,智能制造正加速融入智能化元素,以工业大模型为代表的行业大模型已成为发展的必然趋势,因此,针对智能制造行业大模型展开深入研究,显得尤为迫切。

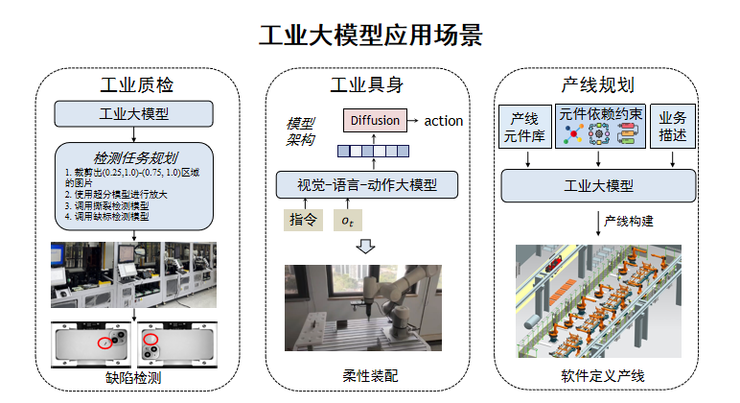

在本项目中,我们围绕几个关键方向开展了应用示范探索:其一,如何将传统基于规则的小模型质检方式,升级为大模型驱动的质检;其二,开展工业具身智能研究,推动大模型与机器人深度融合;其三,进一步探索大模型在工业编程领域的应用——例如,能否让大模型生成PLC程序,从而实现对整条产线的优化?这是我们项目初期确立的几个重点问题。

传统模型在具有明确工艺机理、且受成本制约的工业场景中,存在一定的缺陷。我们通过梳理发现,现有数据往往缺乏对工业机理、工业约束与成本约束的控制;同时,模型的训练与推理也面临算力与效率的双重挑战。这些不足,正是我们开展此项新研究的出发点。

接下来,我将以点线结合的方式,向大家汇报我们近一年来的研究进展及最新思考。我们主要针对三大挑战展开攻关:一是行业应用中的数据短缺问题;二是工业模型重训练与微调时算力网络资源的不足;三是工业场景对推理效率的严苛要求。围绕这些挑战,我们在四个方向进行了布局:数据制备、模型规划、分布式训练以及推理加速,其中特别聚焦于以视觉语言模型(VLM)、视觉语言动作模型(VLA)为代表的具身模型的加速。

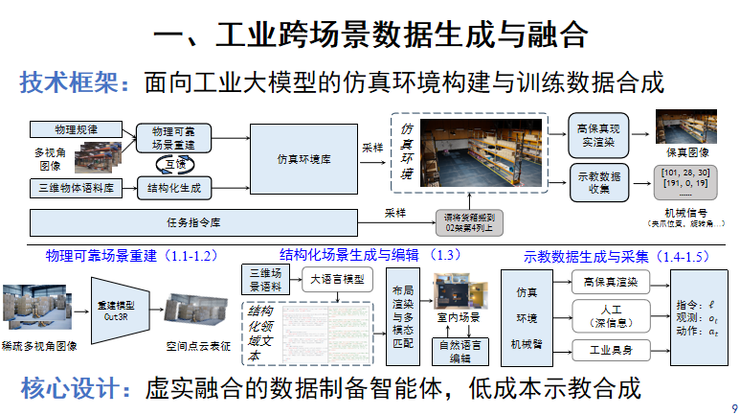

首先是工业跨场景数据的生成与融合。这里我主要以具身智能与工业场景结合为例。现有数据多通过遥操、工厂记录等方式采集,成本高、局限性大,且难以嵌入背后的工业机理知识。

为此,我们提出了虚实融合的数据制备智能体框架,旨在实现低成本、高质量的合成数据生成。项目周期为三年,目前已完成约三分之一。

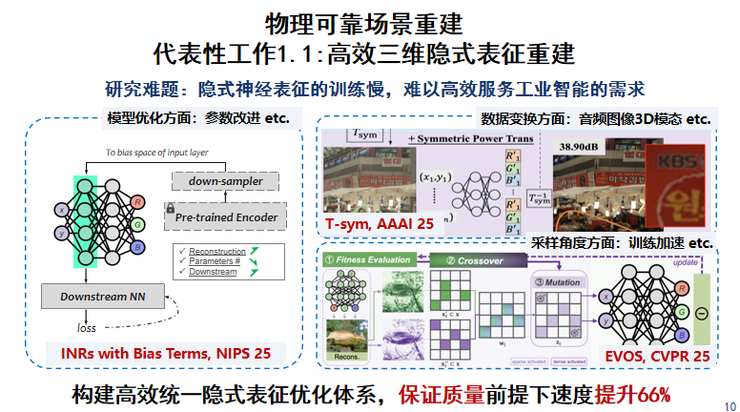

我们主要在以下三方面取得了进展:一是物理可靠场景的重建,经历了从影视、声音、网络至3D高斯的进展;二是结构化场景的生成与编辑;三是探索利用大模型进行场景泛化与数据生成。相关工作已发表为论文,考虑到今天可能大部分观众来自产业界,在此选取部分内容展开说明。

我们首先探索了利用NeRF(神经辐射场)等隐式神经表征来刻画工业场景所需的多模态数据。这类表征具有跨模态兼容性强的优点,能够统一表达音频、时序、3D及2D数据,但其缺点是速度慢,因此我们的工作重点围绕加速展开,包括优化3D数据采样方向、以及针对2D数据重点进行减枝与优化,从而显著提升了隐式神经表征的效率。

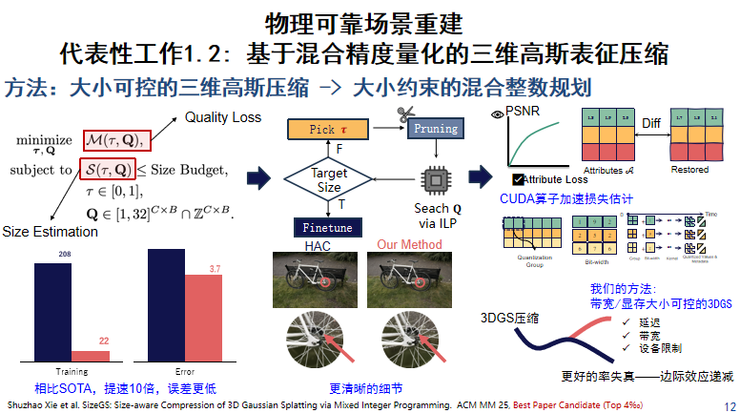

然而,3D隐式神经表达的速度瓶颈依然突出。为此,在第二阶段,我们将重心聚焦于可视化3D数据,并将研究范式从影视声音表达过渡到3D高斯表征,但3D高斯模型体量较大,对大范围场景进行表征和传输时,仍面临存储与带宽的压力。

我们在现有工作基础上进行了拓展:当前研究大多集中于提升失真性能,却难以在给定存储大小限制下重建场景,我们重点解决了这一问题。

此项工作主要包含几个部分:首先,通过测量分析,我们明确了3D高斯重建中与模型大小最相关的超参数及其影响关系,从而改变了传统“先重建后优化”的范式,转向在训练中直接针对高敏感度参数进行优化。同时,我们在算子层面也进行了加速。图中展示了我们的实验效果,其核心优势是能将模型压缩到足够小。

在当前一味追求重建质量的红海竞争中,我们从延迟、带宽与设备限制角度对3D高斯进行优化,这一思路获得了ACM Multimedia评委会的认可,成为1500余篇投稿中入选最佳论文候选的6篇之一。

我们相信,这项技术不仅可用于预训练数据制备,也将推动沉浸式多媒体体验的发展,其核心挑战依然是带宽与质量之间的平衡。

前两项工作主要关注数据的底层表征。在获得表征后,还需将其编排成完整场景。为此,我们开发了基于大模型的结构化场景生成与编辑方法。

首先,我们尝试将场景结构化为JSON或XML等格式,进而利用大模型进行编辑。当然,这不可避免地会产生“幻觉”问题。我们引入了一种力引导结构来消除违背常识的布局,例如防止沙发嵌入墙体或物体姿态不合理。经过优化,我们能生成既真实又多样化的场景布局。

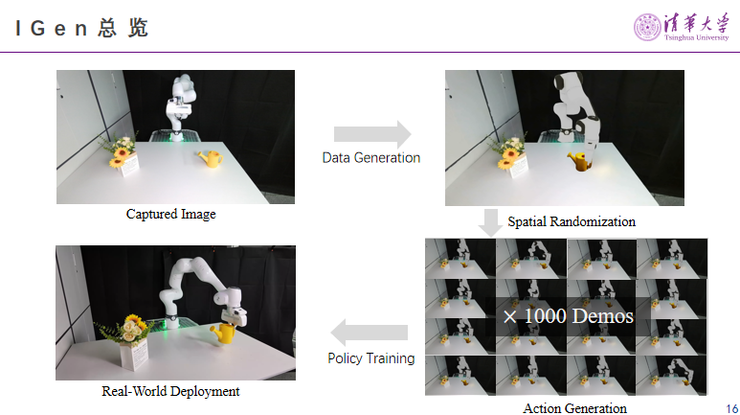

拥有了场景和物体资产后,下一步便与本次会议的主题紧密相连:我们能否制备出真正有用的数据?这是对我们已有多个模块的综合应用。核心问题很直接:能否不通过人工示教或遥操,就让机器自主运动并完成任务?既让语言类模型已经有了泛化能力,我们又可以相对比较真实、快速地生成数据,这是我们的初衷。

这个初衷想达到什么样的效果?

我们拍摄一张实验室真实场景的照片,不进行任何示教,就凭空仿真去生成一系列的这个行为记录,用行为记录数据对VLA模型进行微调,它能否工作?

我们测试了这一流程的可行性。结果表明,该流程充满希望,尽管目前仍存在一些边界案例。模型已能识别操作点并泛化出运动轨迹,但偶尔仍会出现不满足物理约束或动作不合理的情况。

在实验室环境下,这样生成的示教数据已经具备实用价值。

例如图示,完全无需人工示教,虽然生成的动作在重心平衡、操作点定位上存在偏差(如浇花时未考虑水杯满溢状态的重心变化),但模型成功率从零提升到了75%。我们甚至发现,遥操100条数据与我们自动生成1000条数据所能达到的效果是相近的。

这是我们在不同场景下的实验结果。目前受限于实验室本体与场景的规模,我们希望未来能对此框架进行更大范围的扩展。我们已经部分解决了生成速度、任务泛化与场景编排的问题。展望未来,在不同本体协作的背景下,是否会产生新的有趣现象?我们也期待与各位同行深入交流。

在数据制备的最后部分,我们还探索了智能体级别、决策级别的数据制备。具体场景是:在具身智能研究中,多个智能体需协作完成任务,如何制备这类数据?我们搭建了一个仿真环境,让多个智能体在同一3D场景中协作,并记录其交互数据,作为未来训练智能决策的基础。

在此过程中,我们重点解决了智能体间的协作维护问题,设计了一种分布式信念结构,以实现高效通信。基于此,智能体能够以尽可能少的通信量,协同完成打扫、收纳、侦查、巡检等任务。

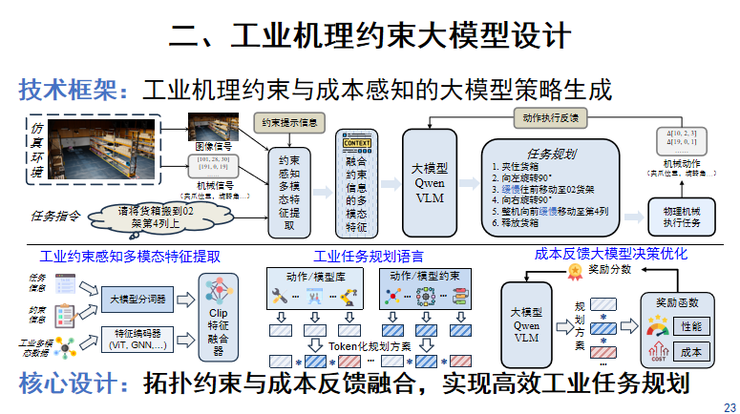

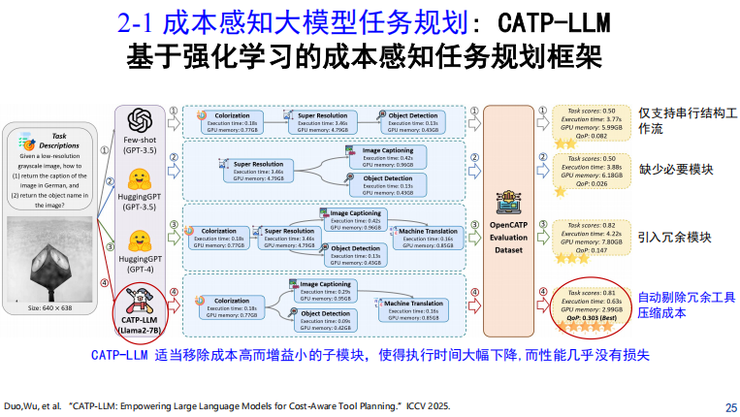

第二部分,是针对工业机理约束的大模型设计。需要澄清的是,我们不是做基模的设计,而是研究如何利用大模型来编排策略、工具链及其他智能体。工业场景的核心约束之一是成本,这不仅指推理成本,更包括所串联工具链本身的运行成本。为此,我们研究了融合拓扑约束与成本反馈的高效任务规划方法。

这是我们的总体框架。传统大模型调用工具也能完成任务,但其产生的动作序列成本可能较高,例如导致机械臂不必要的弯折或调用高算力算法。

为控制成本,我们进行了两方面设计:一是将各类工具Token化,使其能被语言模型像处理词汇一样进行编排;二是将任务执行产生的成本消耗转化为奖励信号,通过强化学习过程来优化工具调用策略。

大家可能会问:将大模型用于娱乐对话尚可,但在视频处理、工业控制等严肃场景,其成本与延迟是否可接受?为此,我们与字节跳动合作了一个项目,针对视频服务场景,研究大模型在带宽预测、码率优化等任务中的实际效能。

基于真实数据的测试,我们发现了一些规律:

首先,大模型确实具备良好的泛化能力,能够适应网络领域的任务,我们对码率自适应、任务调度、带宽预测三类任务进行了验证。其次,在网络任务中,模型性能似乎存在某种“缩放定律”提前饱和的现象,未必需要特别大规模的模型。此外,我们提出了大模型路由机制:并非所有任务都需经过大模型处理,常规任务可直接由传统规则或算法处理;只有当任务超出传统算法能力范围时,才路由至大模型,从而在某种程度上保证软性的延迟上限。

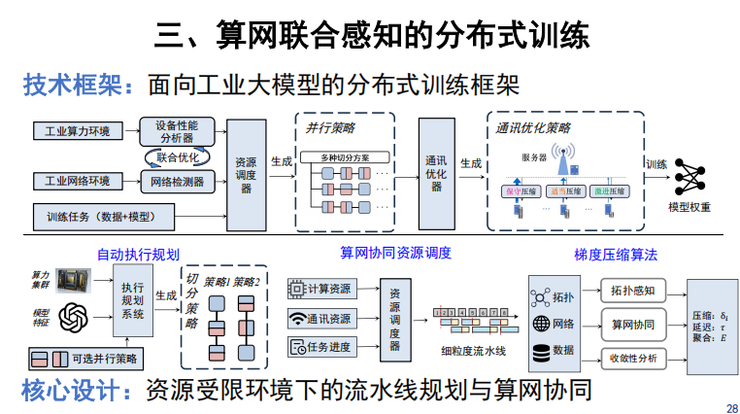

第三部分,是关于弱算力、弱网络环境下的分布式训练。这部分研究起步稍晚,目前我们已完成流水线规划和梯度压缩方面的工作,目标是在算力网络资源受限的条件下,更高效地利用资源对模型进行后训练或微调,以适应不同场景需求。

这两部分工作理论性较强。

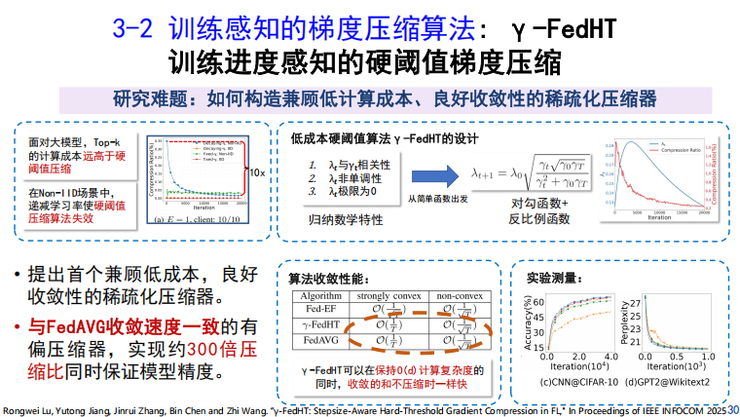

我们改进了Top-k梯度压缩方法,该方法虽能有效减少通信量,但在非独立同分布数据场景下性能可能下降。我们提出了一种新的压缩机制,使其在联邦学习等场景下能达到与未压缩相当的收敛性能。

无论模型是预训练还是微调得来,最终都需在类工业或工业场景中快速部署。我们重点针对具身智能模型(如OpenVLA框架)进行加速优化。与通用语言模型相比,这类模型包含几个显著模块:视觉感知、视觉语言理解(VLM)以及策略生成(通常基于扩散模型)。我们的工作可概括为对这三部分分别进行优化,手段包括参数量化、输入量化、通道剪枝以及KV Cache优化。

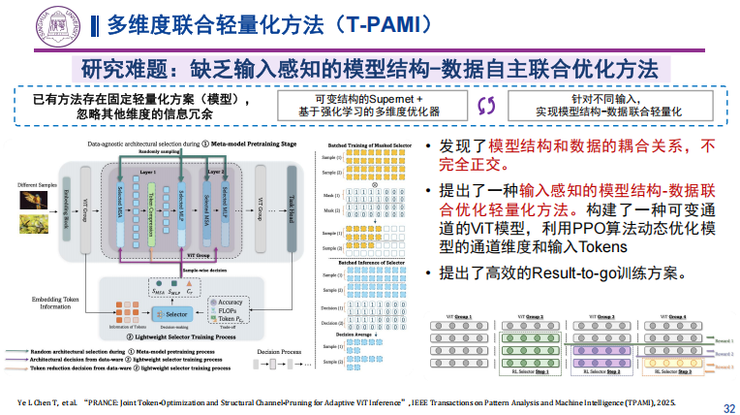

首先,在视觉感知部分,其输出数据受模型参数与输入数据通道的共同影响,我们发现模型结构与输入数据之间存在耦合关系。因此,我们提出了一种多维度联合轻量化方法,针对感知模块进行加速:对于某些数据,在数据层面进行剪枝对后续任务影响更小;而对于其他数据,则更适宜在模型层面进行过滤,这些特性能够在我们框架中被自动学习。感知数据输入后,需经VLM处理。我们对此也进行了优化,主要发现时间与空间维度可以联合压缩:在VLM感知阶段,Token序列具有关联性,不可随意混排;同时,不同Token的重要性也不同。我们据此提出了时空联合压缩优化框架。

接下来是策略生成部分的扩散模型加速。

值得一提的是,在我们实验室的测试中,前端的感知与VLM部分耗时约占3%,策略生成部分约占1%,但两者均有加速空间。对于扩散模型,我们主要通过缓存机制,以存储换计算。我们的特点是将KV Cache的粒度细化至“块”级别,这虽然增加了缓存单元的数量,但也为优化提供了更细的指导。我们摸索出了“块”在时序上的参考规律。

初步实验表明,在算法相同的情况下,仅优化“块”缓存策略就能带来显著的速度提升。

进一步地,我们不仅利用“块”在时序上的参考性,还探索了同一transformer模块内不同“块”之间的空间参考性。我们发现,同一空间内的“块”也具备相似性,可相互参考,从而进一步节省计算,我们还观察到一个有趣现象:在动作生成过程中,只需参考后续的部分“块”,而对前面序列的参考可以大幅减少。

下面简要介绍我们在专项任务中开展的应用场景示范。

首先,针对智能产线机器人。我们融合示教数据与生产数据对模型进行微调,再结合前述加速技术,逐步解决单点问题,最终集成为复杂的工程系统,使其能在真实产线场景中可靠工作。

第二,针对质检任务。我们利用大模型进行工具调用。在某些行业企业中,质检部门已积累了成百上千个检测工具,我们的方法能结合成本考量,智能调用这些现有工具链。

最后是总结与展望。

我们的工作是从通用大语言模型向工业大模型过渡的探索。我们发现,工业大模型在数据层面需要融合3D信息与物理约束,场景需多样化;在训练层面需适应弱网弱算环境;在训练与推理层面,均受到效率与具体场景的严格限制。

我们承担的重点专项隶属于国家基金委工业互联网方向。结合工业互联网与边缘网络的发展趋势,我们未来两至三年的重点攻克方向包括:模型加速、语义通信、网络自主化以及多智能体协同等。

以上是我今天的分享内容,涵盖了我们团队的开源项目进展及实验室成果转化情况。

谢谢大家。

雷峰网原创文章,未经授权禁止转载。详情见转载须知。