在大模型竞速进入推理能力深水区的 2025 年,一支神秘的团队悄然登场。他们不是来自一线大厂的 AI Lab,也没有高调预热和融资造势,而是在 Hugging Face 低调开源了一款 32B 的推理模型:AM-Thinking-v1。

令人惊讶的是,这个中等规模的稠密模型,在多个关键推理评测中击败了 DeepSeek-R1,并与超大规模的 MoE 模型Qwen3-235B-A22B、Seed1.5-Thinking 不相上下。

这款模型背后的团队,是国内一个从未对外披露的研究团队——A-M-team。他们不依赖私有数据、不依赖海量计算资源,仅凭开源底座和训练管线的极致设计,就做出了开放社区 32B 级别中最强的推理模型。

论文链接:https://arxiv.org/pdf/2505.08311

性能全面超越 DeepSeek-R1:32B 模型中的“黑马”

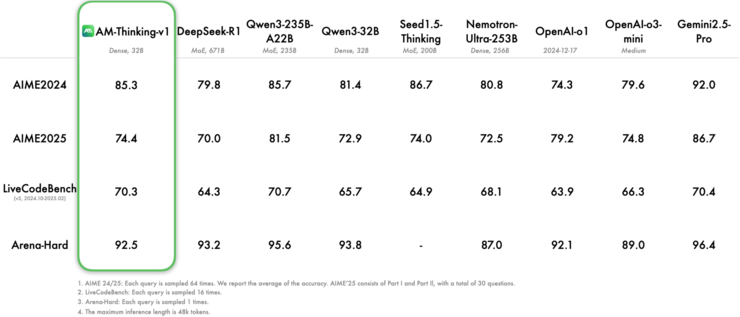

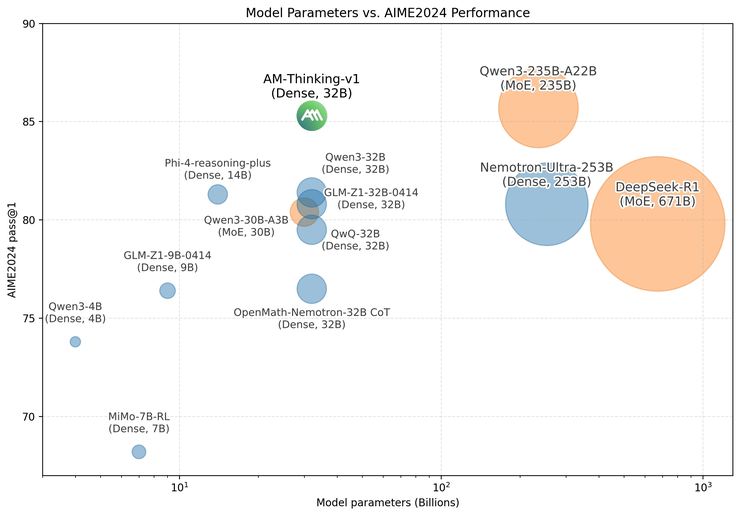

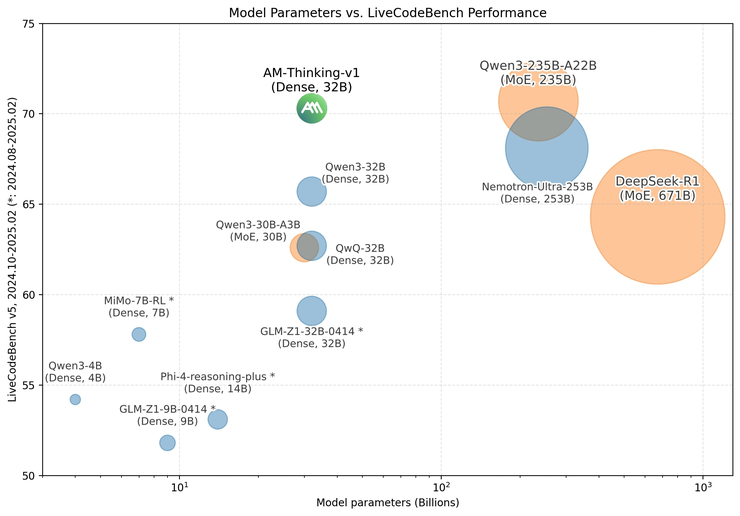

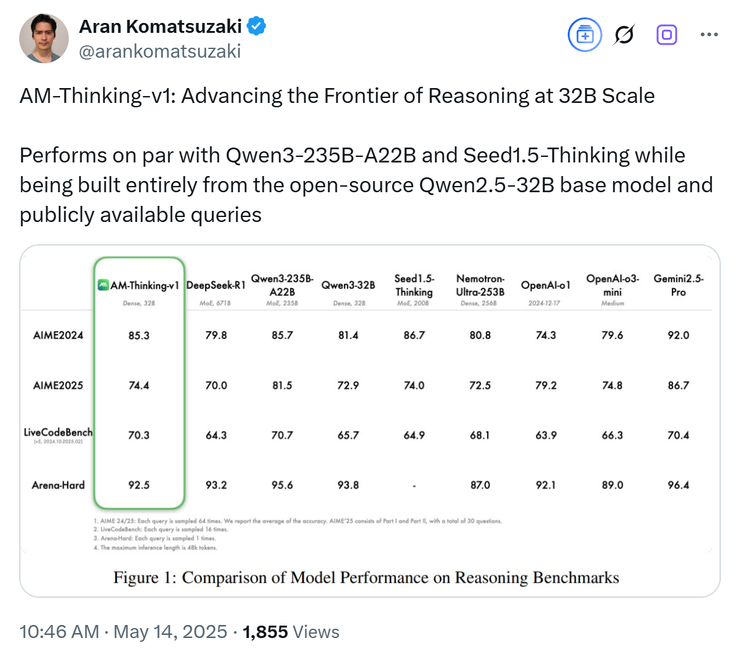

在当前主流评测中,AM-Thinking-v1 也交出了极具冲击力的成绩单,仅 32B 的结构在数学推理(AIME 系列)和代码生成(LiveCodeBench)中分别取得了 85.3 和 70.3 的高分,不仅全面超越了 DeepSeek-R1(671B MoE 架构),还逼近甚至追平了 Qwen3-235B-A22B 和 Seed1.5-Thinking 等超大规模 MoE 模型的成绩。

把“小体积,大推理”的极限范式展现得淋漓尽致。

值得注意的是,AIME 系列题目来自美国数学邀请赛,结构复杂、要求精准,历来是衡量模型逻辑思维能力的金标准;LiveCodeBench 则强调代码可执行性和稳健性,数据污染难度高,是真实场景下“思考-编码-验证”链条的严苛考验。

AM-Thinking-v1 模型测试得分表

AIME2024 不同模型尺寸效果对比;x 轴为模型尺寸,y 轴为分数

LiveCodeBench 不同模型尺寸效果对比;x 轴为模型尺寸,y 轴为分数

推特大 V Aran Komatsuzaki 也下场转发,并配文:AM-Thinking-v1 正以 32B 的规模推进着推理前沿性能的边界。

分数之外,是更具实际意义的任务。当研究人员用 AM-Thinking-v1 去解决典型的“旋转三角形中红球反弹”问题时,AM-Thinking-v1 展现出了多步逻辑极强的理解,给出了完整的运动轨迹模拟和对于小球碰撞的判断。

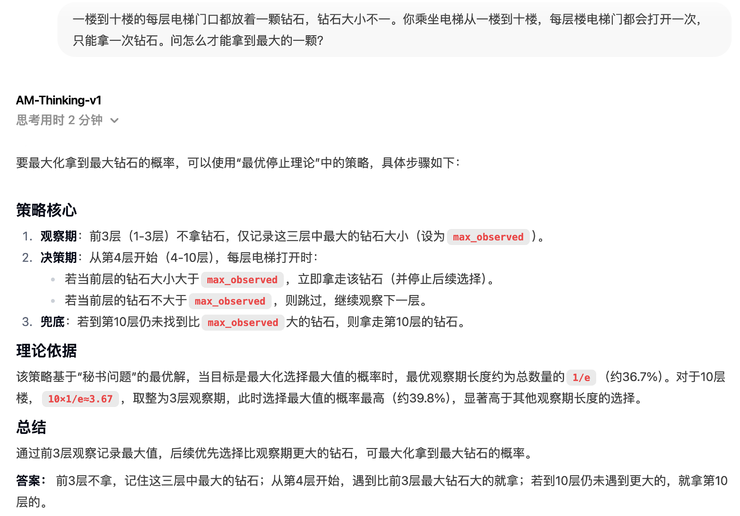

而在逻辑推理任务中,AM-Thinking-v1 也能保持非常稳定的思考过程。

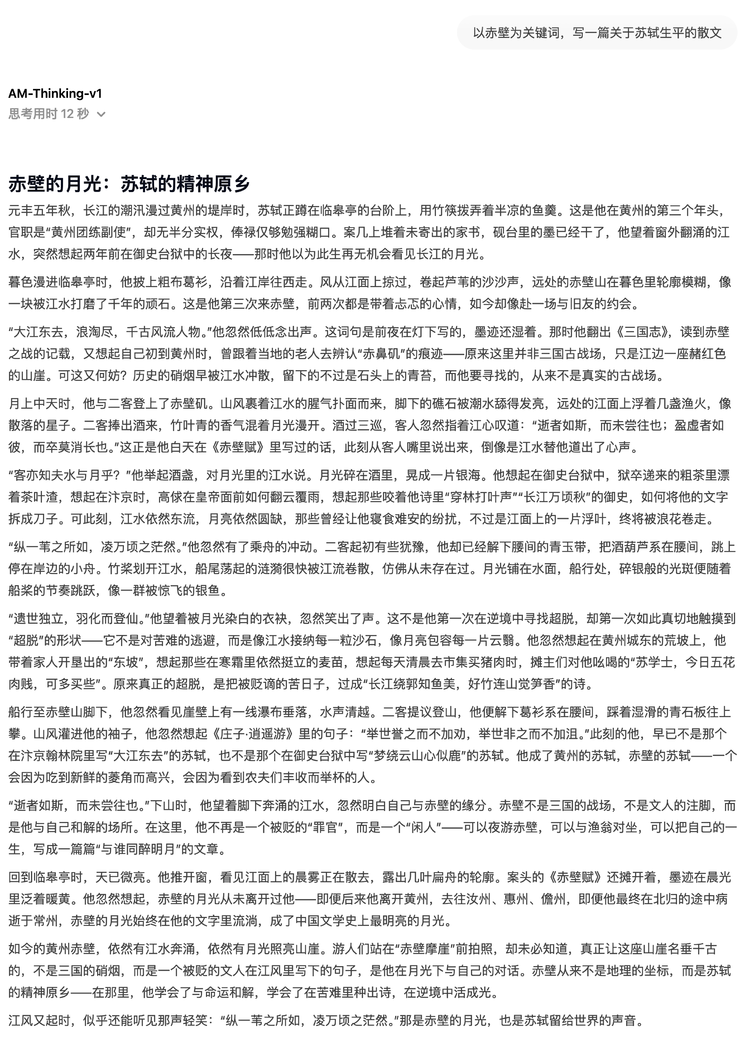

在长文本写作能力的测试中,AM-Thinking-v1 在表达逻辑和意象捕捉方面也展现出了初步的组织能力。

32B 模型的新上限,是这样“训”出来的

与追求超大规模和大数据堆叠不同,A-M-team 的关键突破在于如何用有限的计算和开源数据,最大化32B模型的推理能力。

他们设计了一整套后训练(post-training)方案,其中包括冷启动式监督微调、通过率引导的数据筛选机制以及双阶段强化学习(Dual-stage RL)。

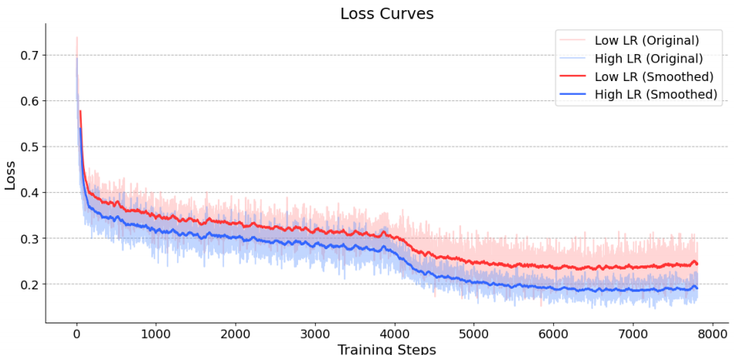

首先在监督微调(SFT)阶段,团队用了一个相对激进但效果很好的设置:把学习率拉到了 8e-5,batch size 也做了加大,还支持最长 32K 的输入长度。训练样本被特别设计成“先思考再回答”的格式。

这个设计帮助模型建立了“先想清楚、再说话”的好习惯。而且,训练中还能明显看到模型越来越懂得控制长度、避免啰嗦——这些变化在平均生成长度和终止率上都有反映

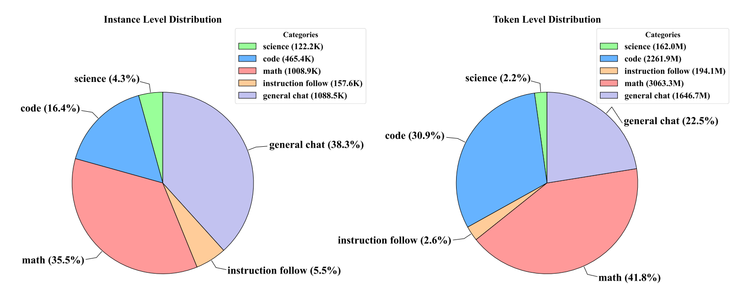

其次在数据这块,团队完全依靠开源资源,从数学、代码、科学推理到指令跟随和通用对话,总共整理出了五类核心任务的数据。

他们花了大量时间做清洗:不仅去重、改写问题,防止和评测集“撞题”,还对数学数据进行严格验证,甚至用 DeepSeek-R1 和 o4-mini 来交叉比对标准答案。生成的训练样本也经过层层筛选,比如用 PPL 算分、检查重复短语和结构完整性,最终留下的数据干净又靠谱。

在最后的强化学习(RL)阶段,团队选用了 GRPO 这种轻量级算法,还特别搞了个“难度感知”的策略,意思是:先挑一些模型做得不太好的题来练,等熟练了,再加入一些通用对话和指令跟随任务来拓展能力。

奖励机制也挺讲究:数学和代码类的问题用规则验证或者直接跑沙盒程序验证答案;而像 open-ended 回答这种,就让 LLM 来打分,从有用性、准确性、连贯性这三方面评估,保证模型在各方面都能进步。

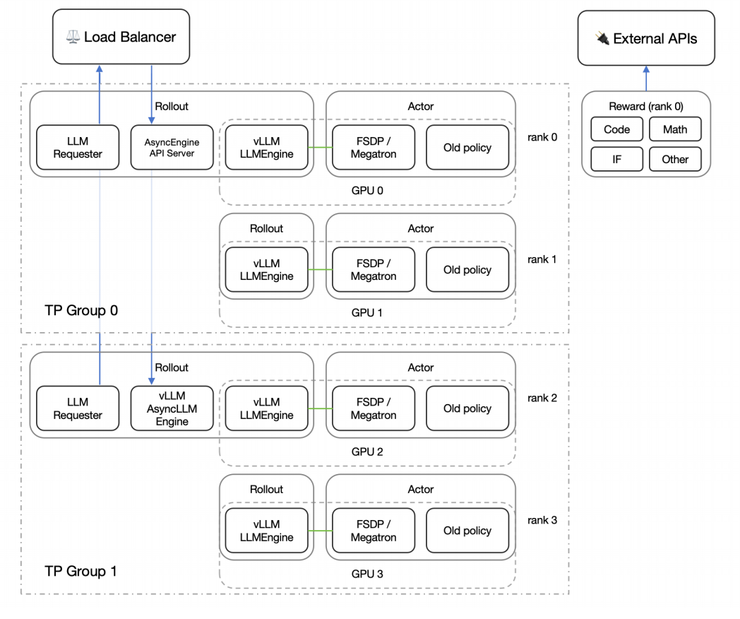

当然,为了让整个 RL 训练高效跑得动,A-M-team 还在工程上动了不少脑筋。比如他们把推理和训练分开,用了 streaming rollout 的方式,还配了个前端负载均衡器,能根据每张 GPU 的实际压力动态分配任务,最大限度避免“有的卡闲着、有的卡累死”的情况。不仅训练稳,还能大大节省时间和算力

总的来说,虽然 AM-Thinking-v1 已经在推理上做得很出色,但它目前还不支持函数调用、多模态输入,对低资源语言的能力也有待验证。

不过,即便如此,它已经把 32B 模型的性能潜力挖掘到了极致,也为开源 LLM 社区提供了一个值得借鉴的思路:不靠堆参数、不靠私有数据,通过细致训练设计,也能做出足够聪明的模型。

为什么要做一个 32B 推理模型?

在当前大模型发展趋势中,主流路线正不断追求更大的参数规模、更复杂的架构(如 MoE)、更庞大的训练数据和更昂贵的训练资源。但这条路线的成本极高,同时也带来了模型部署难、推理延迟高、适配门槛大等一系列现实问题。

A-M-team 选择反其道而行之,专注在 32B 这一“中尺度模型”的参数区间,其实背后也有有着明确的考量:他们想探索一种在计算资源可控、数据完全开源的条件下,也能实现强大推理能力的路径。

具体来说,32B 是一个对研究与应用都更友好的“黄金尺寸”:

足够强大:相比 7B 或 13B 模型,32B 在能力上能支持复杂的数学推理和代码生成,具备执行严肃 reasoning 任务的基础;

成本可控:相比 100B、200B 甚至 670B 的巨型模型,32B 模型训练与推理资源需求显著更低,更适合在企业或研究机构内部复现、部署和迭代;

部署更友好:在单节点或小规模集群上即可运行,可应用于更多落地场景;

MoE 替代探索:它也是对 MoE 路线的替代探索,A-M-team 想要验证,不使用专家模型,仅靠稠密结构和扎实的后训练设计,是否也能达到甚至超越 MoE 模型的表现。

AM-Thinking-v1 正是在这样的问题驱动下诞生的:一个不依赖私有数据、没有特殊硬件依赖、完全基于社区资源训练而成的中尺度模型。

而它的表现也正好印证了这个方向的潜力——不仅在 AIME 和 LiveCodeBench 等高难度任务上超越了 DeepSeek-R1,还在多个维度接近 Qwen3-235B-A22B 这类百亿级 MoE 模型。雷峰网(公众号:雷峰网)简而言之,AM-Thinking-v1 想要回答的是一个关键问题:“大模型能力的上限,能不能用更小的体量实现?” 结果是肯定的。

而这正是 32B 推理模型的价值所在。

雷峰网原创文章,未经授权禁止转载。详情见转载须知。